در ماههای اخیر، متا به عنوان یکی از پیشروترین شرکتهای عرصه هوش مصنوعی، مدلهای جدیدی با نامهای Llama 4 Maverick و Llama 4 Scout معرفی کرده است. اما در پی این رونمایی، شایعاتی مطرح شد که متا ممکن است در بنچمارکهای این مدلها دست به تقلب زده باشد. ادعاها بیشتر حول محور استفاده از دادههای تست برای آموزش مدلها و ثبت امتیازهای غیرواقعی در معیارهای ارزیابی، متمرکز است. این گزارش به بررسی واقعیت این ادعاها و تحلیل پاسخهای مدیران ارشد متا میپردازد.

ماجرای شایعه: چرا متا متهم شد؟

ماجرا هنگامی آغاز شد که برخی پژوهشگران در شبکه اجتماعی ایکس (پیشتر توییتر) تفاوتهای چشمگیری بین نسخه عمومی مدل Llama 4 Maverick و نسخهای که در بنچمارک LM Arena اجرا شده بود، مشاهده کردند. ادعا شد که این تفاوتها ممکن است نشانهای از استفاده متا از نسخههای خاص و بهینهشدهای برای ثبت امتیازات بهتر باشد. بهعلاوه، برخی گمانهزنیها بر این باور بودند که متا ممکن است دادههای تست را بخشی از دادههای آموزشی مدلهای خود قرار داده باشد.

«این ادعا که متا مدلهای Llama 4 را با استفاده از مجموعه دادههای تست آموزش داده است، بههیچوجه صحت ندارد.»

احمد الضاحل، معاون واحد هوش مصنوعی متا

تحلیل ادعای شایعه: واقعیت یا سوء تفاهم؟

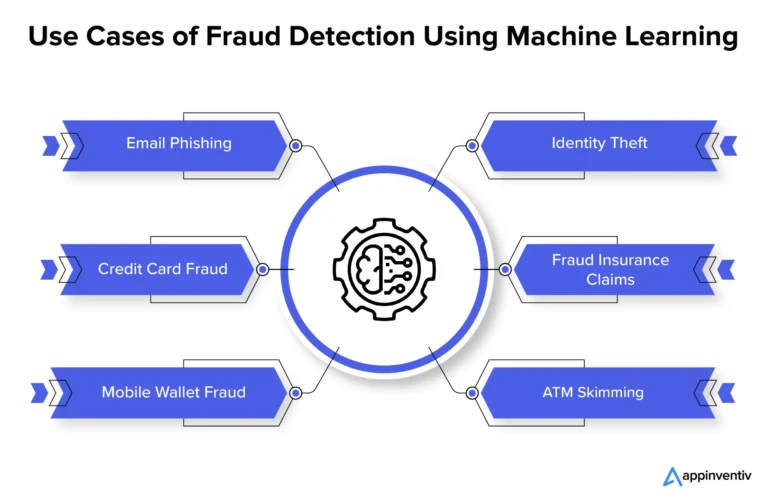

به طور کلی، مجموعه دادههای تست در حوزه هوش مصنوعی، برای ارزیابی عملکرد مدل پس از تکمیل فرایند آموزش استفاده میشوند. این دادهها نباید در فرایند آموزش به کار روند، زیرا میتوانند نتایج بنچمارکها را بهطور غیرطبیعی و اغراقآمیز تحت تأثیر قرار دهند. مواردی همچون افزایش دقت مدل در دادههای خاص اما کاهش توانایی آن در موقعیتهای واقعی، از این قبیل مشکلات هستند.

با این حال، احمد الضاحل در مصاحبهای صراحتاً عنوان کرد که تمامی روندهای توسعه و انتشار مدلهای متا مطابق با استانداردهای صنعتی و شفافیت صورت گرفته است. او همچنین تأیید کرد که استفاده از نسخههای آزمایشی و بهبودهای تدریجی مدلها ممکن است باعث اختلاف عملکرد میان نسخههای مختلف شود.

چالشهای پیادهسازی و ارزیابی مدلهای هوش مصنوعی

یکی از چالشهای مطرح در صنعت هوش مصنوعی، زمانبر بودن فرایند انتشار و پایداری نسخههای عمومی مدلها است. به گفته الضاحل، مدلهای Llama 4 بلافاصله پس از آمادهسازی اولیه منتشر شدهاند و این احتمال وجود دارد که برخی کاربران تجربه کیفیت متفاوتی را در بسترهای مختلف ابری داشته باشند.

این موضوع علاوه بر شفافیت در عملکرد مدلها، به ایجاد اعتماد عمومی در مورد معیارهای بنچمارک شرکتها نیز ارتباط مستقیم دارد. اگرچه متا بر عملکرد و شفافیت خود تأکید دارد، اما این اتهامات نشاندهنده نیاز به استانداردسازی بیشتر برای معیارهای ارزیابی مدلهای هوش مصنوعی است.

نگاهی به واکنش جامعه علمی

واکنشها به این شایعات در جامعه علمی دوگانه بوده است. گروهی بر این باورند که عملکرد متا در اطلاعرسانی شفاف بوده و شایعات بیاساساند. در مقابل، برخی پژوهشگران معتقدند که عدم ارائه جزئیات دقیقتر در مورد دادههای آموزشی و معیارهای ارزیابی، میتواند به کاهش اعتماد عمومی منجر شود.

تصمیمگیری در مورد صحت این شایعات نیازمند بررسی بیشتر دادهها و همکاری نزدیک صنعت هوش مصنوعی با سازمانهای بیطرف است.

دیدگاه آینده: چه چیزی در انتظار است؟

این جنجالها نکات مهمی را برجسته میسازند: اولاً، نیاز به شفافیت بیشتر در ارائه گزارشهای فنی و ثانیاً، لزوم تدوین استانداردهای بینالمللی برای ارزیابی عملکرد مدلهای هوش مصنوعی. انتظار میرود که شرکتهایی مانند متا، تلاش کنند تا با ایجاد همکاریهای گستردهتر با متخصصان مستقل، از ایجاد چنین سوء تفاهمهایی در آینده جلوگیری کنند.

با توجه به جایگاه متا بهعنوان یکی از رهبران عرصه هوش مصنوعی، هرگونه اقدام این شرکت میتواند تأثیرات گستردهای بر اعتماد عمومی به فناوریهای این حوزه داشته باشد. از این رو، رویکردهای آینده این شرکت از اهمیت بسزایی برخوردار خواهد بود.

نتیجهگیری نهایی

بنابراین، اگرچه متا به طور واضح این اتهامات را رد کرده است، اما بررسی دقیقتر ساختار و روشهای اعمال شده در بنچمارکها ضروری به نظر میرسد. شفافسازی و رعایت اصول علمی میتواند تضمینکننده اعتماد کاربران به تمامی مدلهای هوش مصنوعی باشد.

نظر شما در مورد این مجادله چیست؟ آیا فکر میکنید که چنین اتهاماتی علیه شرکت بزرگی مانند متا، واقعیت دارد یا صرفاً سوء تفاهم هستند؟ دیدگاه خود را در بخش نظرات با ما در میان بگذارید و در این بحث شرکت کنید!

دیدگاه ها