شرکت متا اخیراً اقداماتی چشمگیر در راستای بهینهسازی و توسعه مدلهای هوش مصنوعی خود انجام داده است. یکی از تصمیمات اخیر این شرکت، استفاده از محتواهای عمومی کاربران اروپایی در پلتفرمهای فیسبوک و اینستاگرام برای آموزش الگوریتمهای هوش مصنوعی است. این اقدام بار دیگر بحثهای زیادی در مورد حفظ حریم خصوصی، نیاز به تنوع دادهها و مسئولیتپذیری شرکتهای فناوری را برانگیخته است. در این مقاله به بررسی جامع این موضوع، چالشها و چشماندازهای مرتبط خواهیم پرداخت.

تصمیم متا: استفاده از دادههای عمومی کاربران اروپایی

متا اعلام کرده که تصمیم دارد استفاده از محتوای عمومی کاربران اروپایی فیسبوک و اینستاگرام را برای آموزش مدلهای هوش مصنوعی خود آغاز کند. این اقدام پس از توقف موقتی این فرآیند در سال گذشته، به دلیل فشارهای قانونی اتحادیه اروپا در حوزه حفظ دادهها، صورت گرفته است.

این محتوای عمومی شامل پستها، کامنتها و تعاملات کاربران با ابزارهای هوش مصنوعی متا خواهد بود. نکته قابل توجه این است که پیامهای خصوصی کاربران و نیز اطلاعات کاربران زیر ۱۸ سال از این پروسه مستثنی هستند. این موضوع نشانهای از توجه به برخی الزامات قانونی و اخلاقی است، اما آیا کافی است؟

پاسخگویی متا به کاربران: لینک مخالفت و شفافسازی

متا اعلام کرده است که قصد دارد پیامهایی درونبرنامهای و ایمیلهایی برای کاربران ارسال کند تا آنها را از این تصمیم مطلع سازد. همچنین، لینکهایی برای اعلام مخالفت و جلوگیری از جمعآوری دادهها از سوی کاربران نیز در دسترس قرار خواهد گرفت. گفتنی است که درخواستهای مخالفت قبلی کاربران نیز به رسمیت شناخته خواهد شد.

«برای ساخت هوش مصنوعی متناسب با جوامع اروپایی، نیاز به دادههایی داریم که تنوع زبانی، محلی و فرهنگی این منطقه را بازتاب دهند.»

– شرکت متا

اهمیت تنوع دادهها: تأثیر بر کیفیت هوش مصنوعی

یکی از دلایل کلیدی متا برای این اقدام، نیاز به دادههایی متنوع و بومی است که بتوانند زبانها، فرهنگها و جوامع متفاوت اروپا را بازنمایی کنند. بدون چنین دادههایی، مدلهای هوش مصنوعی ممکن است تعصبات یا کاستیهایی در تحلیل و عملکرد خود داشته باشند که این موضوع میتواند به چالشهای جدی در زمینه قبول عمومی و مقررات قانونی منجر شود.

شرکتهای دیگری مانند گوگل و OpenAI نیز پیشتر از دادههای کاربران اروپایی برای آموزش مدلهای مشابه خود استفاده کردهاند. این موضوع نشاندهنده رقابت شدید در صنعت هوش مصنوعی برای جمعآوری دادههای آموزشی گسترده و باکیفیت است.

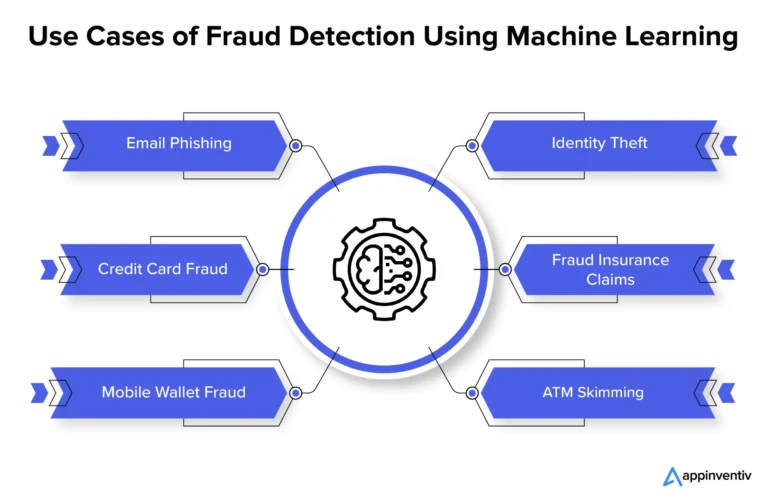

پیامدهای حقوقی و اجتماعی: نظارتهای ادامهدار

در حالی که متا برای آموزش مدلهای خود از دادههای کاربران بهره میبرد، نگرانیهای قانونی و اخلاقی همچنان به قوت خود باقی است. هفته گذشته، کمیسیون حفاظت از دادههای ایرلند تحقیقات جدیدی درباره نحوه آموزش مدل گراک متعلق به xAI آغاز کرد. این نشاندهنده افزایش نظارت بر نحوه استفاده از دادههای کاربران توسط شرکتهای بزرگ فناوری است.

علاوه بر مسائل قانونی، کاربران معمولی نیز ممکن است در مقابل استفاده از محتوای خود برای این منظور مقاومت کنند؛ خصوصاً در زمانی که بحثها پیرامون حفظ حریم خصوصی شدت گرفته است. ایجاد شفافیت و توضیح دقیق در مورد اینکه چگونه دادهها استفاده میشوند، برای حفظ اعتماد کاربران اساسی است.

چشمانداز: تأثیرات و آیندهنگری

اگر متا موفق به استفاده مسئولانه و شفاف از دادههای کاربران شود، این اقدام میتواند به توسعه مدلهای هوش مصنوعی قویتر، دقیقتر و متناسبتر منجر شود که بازتابدهنده نیازها و خواستههای کاربران اروپایی خواهد بود. اما در مقابل، در صورتی که مسائل حریم خصوصی به نتیجهای نرسد، شکاف اعتماد میان شرکتها و کاربران بیش از پیش عمیقتر خواهد شد.

بهطور کلی، آینده مدلهای هوش مصنوعی به شدت به توانایی شرکتها برای ایجاد توازن میان جمعآوری داده، رعایت الزامات قانونی و احترام به حقوق کاربران بستگی دارد.

جمعبندی نهایی

اقدام متا برای استفاده از دادههای عمومی کاربران اروپایی حرکتی مبتکرانه اما پرچالش است که میتواند تأثیرات عمیقی بر صنعت هوش مصنوعی و اعتماد عمومی به شرکتهای فناوری داشته باشد. سوال اینجاست که آیا این رویکرد منجر به موفقیت خواهد شد یا اینکه محدودیتهای قانونی و اجتماعی مانع از اثرگذاری آن خواهند شد؟

حالا نوبت شماست! نظرات خود را در مورد این موضوع با ما به اشتراک بگذارید و بیان کنید که آیا چنین اقداماتی از سوی شرکتهای فناوری قابل قبول است یا خیر؟ چقدر به شفافیت متا در این زمینه اعتماد دارید؟ ما مشتاقانه منتظر دیدگاههای شما هستیم!

دیدگاه ها