تکامل سریع فناوری هوش مصنوعی در سالهای اخیر نهتنها انقلابی در تکنولوژی ایجاد کرده، بلکه بسیاری از باورهای ارتباطی و مدیریتی پشت پرده این صنعت را هم زیر سؤال برده است. اکنون یک چالش جدید، بر سر راه مدیرعامل OpenAI یعنی سم آلتمن پدید آمده که توسط یکی از افراد با سابقه شرکت یعنی تودور مارکوف مطرح شده است. این انتقادات پرسشهایی جدی درباره اخلاقیات، شفافیت و مسئولیتپذیری شرکتهایی مانند OpenAI در حوزه هوش مصنوعی برمیانگیزد.

زمینه اصلی انتقادات تودور مارکوف

تودور مارکوف، یکی از پژوهشگران پیشین OpenAI که اکنون در استارتاپ رقیب انتروپیک فعالیت میکند، با ادعایاتی قابل توجه علیه سم آلتمن و سیاستهای OpenAI مواجه شده است. مهمترین محور انتقاد او مربوط به شروط «ضد بدگویی» میشود. طبق این بندها، کارمندان OpenAI از بیان انتقادات علنی نسبت به این شرکت منع شده و بهنوعی تحت فشار اخلاقی و حقوقی قرار میگیرند. مارکوف ادعا میکند که آلتمن درباره این شروط، به کارمندان دروغ گفته و حقیقتگویی را قربانی اهداف مدیریتی کرده است.

«آلتمن فردی بیصداقت است که بهطور مستقیم به کارمندان دروغ میگوید.»

– تودور مارکوف

تناقضها و مدارک منتشر شده

مارکوف میگوید در سال ۲۰۲۴، زمانی که از وجود بندهای ضد بدگویی مطلع شد، این مسئله را در جلسهای با حضور آلتمن مطرح کرد. آلتمن مدعی شد از وجود چنین بندی بیاطلاع است. اما رسانه Vox در ادامه سندهایی را منتشر کرد که نشان میداد آلتمن نهتنها از این بندها مطلع بوده، بلکه خود آنها را تأیید و امضا کرده است. این موضوع به وضوح شفافیت و صداقت مدیریتی آلتمن را زیر سؤال برده و موج جدیدی از انتقادات به عملکرد او و سیاستهای اجرایی OpenAI را بهدنبال داشت.

ادعاهای اخلاقی در برابر سودمحوری

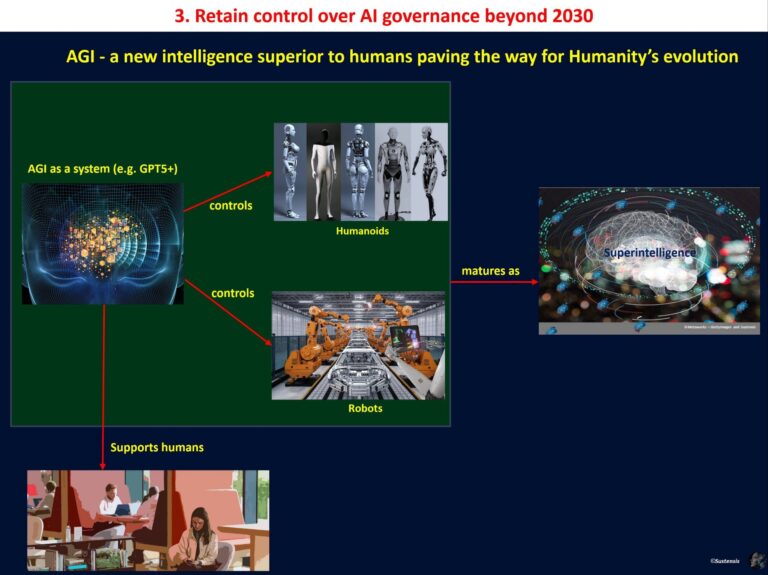

یکی دیگر از محورهای انتقادات، تغییر جهت OpenAI تحت مدیریت آلتمن از یک مؤسسه غیرانتفاعی به یک شرکت تمرکزگرا با اهداف سودمحور است. مارکوف و بسیاری دیگر از مخالفان معتقدند این تغییر نهتنها روح منشور اخلاقی OpenAI را زیر پا میگذارد، بلکه تعهد شرکت به توسعه امن و اخلاقی هوش مصنوعی انسانگونه (AGI) را نیز در خطر قرار میدهد.

OpenAI در منشور خود وعده داده که توسعه AGI باید به نفع همه بشریت باشد و هیچگاه از آن برای مقاصد مضر یا قدرتطلبانه استفاده نشود. با این حال، مارکوف ادعا میکند این منشور بیشتر یک ابزار تبلیغاتی برای جلب توجه عمومی و کارکنان است تا یک راهنمای واقعی برای تصمیمگیریهای سازمانی.

«تلاش برای کسب سود بیشتر از توسعه هوش مصنوعی، مأموریت اصلی OpenAI را به حاشیه برده است.»

– ایلان ماسک

ابعاد گستردهتر چالشهای OpenAI

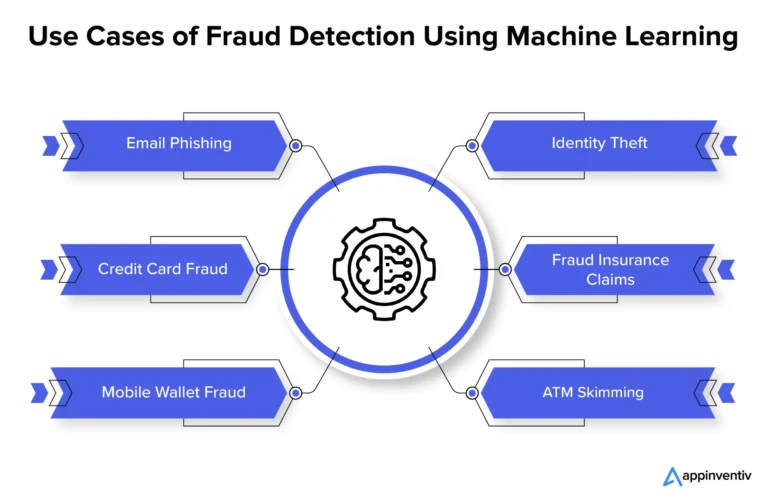

این پرونده فقط محدود به مسائل حقوقی و بندهای قراردادی نیست. مارکوف و مخالفان دیگر معتقدند که OpenAI در مواجهه با چالشهای امنیتی مرتبط با هوش مصنوعی رویکرد محافظهکارانه و واضحی ندارد. آنها بر این باورند که توسعه بیرویه و بدون نظارت فناوریهای آیندهنگر همچون AGI، تمام بشریت را در معرض خطر قرار میدهد. این خطرات شامل مسائل مربوط به حریم خصوصی، تصمیمگیریهای خودکار و سوءاستفادههای احتمالی توسط شرکتهای سودجو میشود.

از طرفی، منتقدان معتقدند OpenAI به جای شفافسازی درباره اهداف و چالشهای واقعی، از نفوذ رسانهای و کمپینهای بازاریابی برای بهبود تصویر عمومی خود بهرهبرداری میکند. این استراتژی در مخالفت صریح با اصولی است که در منشور این شرکت آورده شده است.

نگاهی به آینده: آیا OpenAI به تعهداتش پایبند میماند؟

این حواشی جدید، سؤالات بسیار جدی درباره آینده OpenAI و نقش آن در توسعه هوش مصنوعی مطرح کرده است. آیا این شرکت میتواند اعتماد جهانیان را به دست آورد و مأموریت اصلی خود را بهطور مؤثر دنبال کند؟ یا اینکه فشارهای سودآوری و رقابت با سایر شرکتها مسیرش را تغییر خواهد داد؟

بهنظر میرسد تنها راه حل این چالشها، شفافیت بیشتر در سیاستها و تعامل فعال با جامعه جهانی در حوزه هوش مصنوعی باشد. مثالهایی همچون تشکیل نهادهای نظارتی بینالمللی و همکاری عمومی میتوانند نقاط شروع مناسبی باشند.

نتیجهگیری

سرگذشت OpenAI و چالشهای پیشروی آن، نمونهای ارزشمند از تقابل اخلاق و تجارت در دنیای فناوری است. شاید این شرکت بتواند با شفافیت بیشتر و پایبندی واقعی به منشور خود، آیندهای امنتر برای هوش مصنوعی رقم بزند. با این حال، این مسئله تنها به تصمیمگیریهای داخلی OpenAI محدود نمیشود و نیازمند نظارت گستردهتر از سوی جامعه جهانی و سایر نهادهای وابسته است.

نظر شما درباره این موضوع چیست؟ آیا شرکتهایی مانند OpenAI باید تحت قوانین سختگیرانهتری درباره شفافیت و اخلاقیات قرار گیرند؟ دیدگاههای خود را در بخش نظرات با ما به اشتراک بگذارید.

دیدگاه ها