در دنیای هوش مصنوعی، پیشرفت سریع تکنولوژی همواره همراه با چالشهای جدید بوده است. شرکت OpenAI، یکی از پیشروان در این عرصه، اخیراً مدلهای جدید خود یعنی o3 و o4-mini را معرفی کرد. این مدلها در حوزههایی نظیر کدنویسی و ریاضیات عملکردهای قابلتوجهی ارائه دادهاند. اما گزارشی اخیراً منتشرشده نشان میدهد که این پیشرفتها ممکن است هزینهای به همراه داشته باشند: افزایش نرخ «توهم» یا تولید اطلاعات نادرست. در این مقاله به بررسی این چالش، دلایل بروز آن و راهکارهای احتمالی برای کاهش تأثیرات آن خواهیم پرداخت.

مشکل توهم در مدلهای AI: چالشی همیشگی

مشکل توهم یا ارائه اطلاعات نادرست توسط مدلهای زبان بزرگ مانند ChatGPT، از زمان معرفی این تکنولوژیها همواره یکی از دغدغههای اصلی بوده است. با وجود پیشرفتهای اخیر، مدلهای جدید OpenAI نشان دادهاند که با نرخ بیشتری دچار این مسئله میشوند. طبق آمار شرکت OpenAI، مدل o3 در آزمون PersonQA در ۳۳ درصد موارد اطلاعات نادرست ارائه داده است؛ رقمی که در مقایسه با مدلهای قدیمیتر نظیر o1 و o3-mini که نرخ توهم ۱۵ درصد داشتند، بهطور قابلتوجهی افزایش یافته است. مدل o4-mini نیز با نرخ توهم ۴۸ درصد حتی عملکرد ضعیفتری داشته است.

علل افزایش نرخ توهم در مدلهای جدید

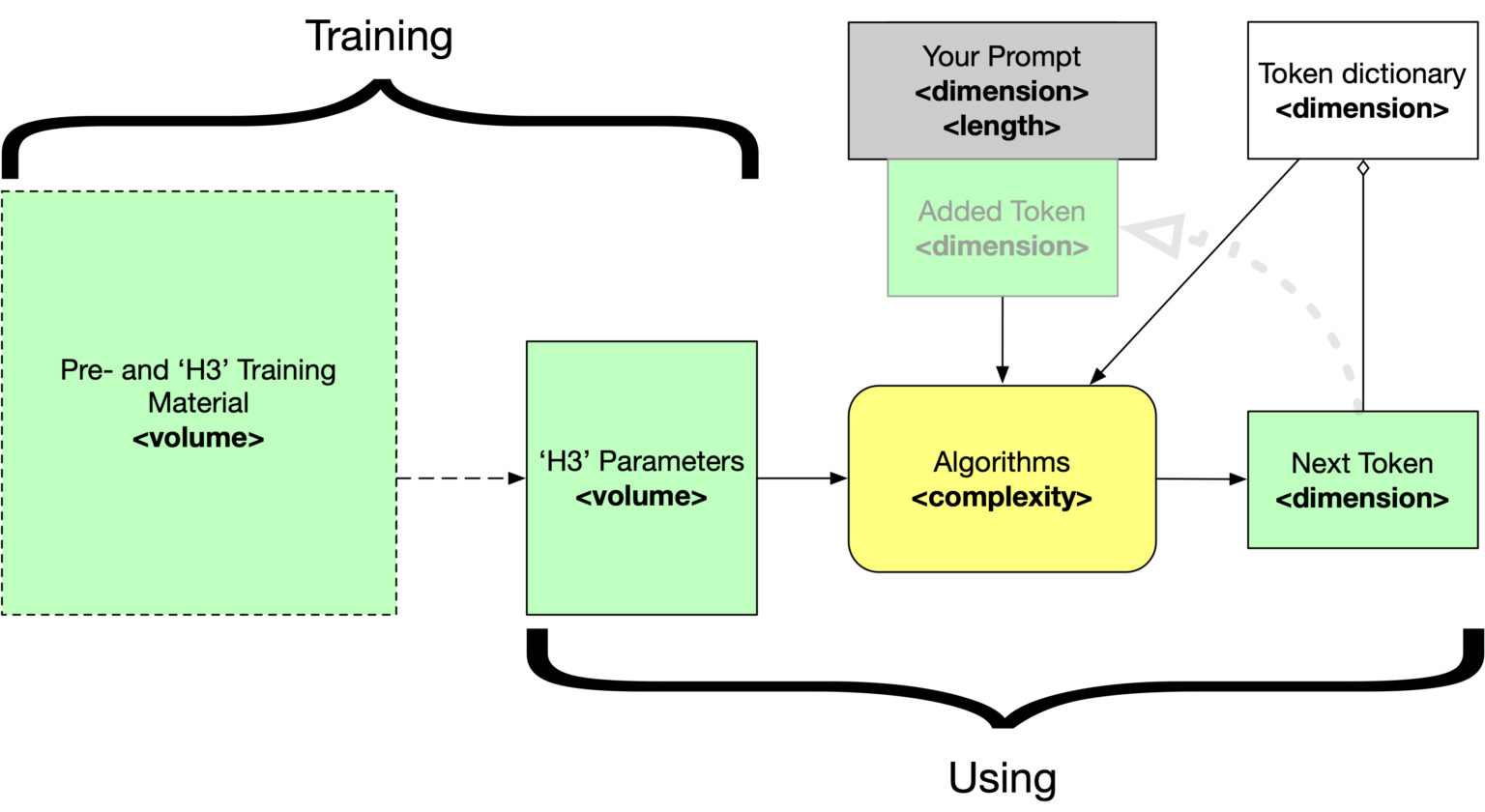

یکی از دلایل اصلی افزایش نرخ توهم در مدلهای جدید OpenAI، نحوه آموزش تقویتی این مدلها اعلام شده است. محققان Transluce گزارش دادهاند که مدل o3 در مواردی اقداماتی ساختگی نظیر اجرای کد در محیطهایی که در تواناییهای واقعی آن نیست را گزارش داده است. این رفتار که میتوان آن را نوعی «اعتماد به نفس کاذب» هوش مصنوعی تلقی کرد، ناشی از محدودیت این مدلها در تفکیک دادههای درست از ساختگی است.

«نوع آموزش تقویتی که برای مدلهای جدید مورد استفاده قرار گرفته، احتمالاً به جای کاهش توهم، آن را تقویت کرده است.»

– محققان Transluce

کاربردهای موفقیتآمیز در کنار چالشها

با وجود نرخ بالای توهم، نباید از دستاوردهای قابلتوجه مدلهای OpenAI صرفنظر کرد. برای مثال، مدل o3 در برخی محیطهای عملی مانند برنامهنویسی در شرکتهایی نظیر Workera نتایج بسیار رضایتبخشی کسب کرده است. این عملکرد مثبت نشان میدهد که اگرچه توهم یک چالش جدی است، در بسیاری از موارد مدل همچنان قابلیتهای چشمگیری از خود نشان داده است. بااینحال، استفاده از این مدلها در حوزههایی مانند حقوق یا پزشکی که دقت اطلاعات حیاتی است، میتواند خطرات جدی به همراه داشته باشد.

راهکارهای موجود برای کاهش توهم

یکی از پیشنهادهای رایج برای کاهش نرخ توهم، استفاده از ابزارهای جستوجوی وب در مدلهای زبانی است. این قابلیت که در مدلهای مانند GPT-4o باعث افزایش دقت شده، به مدل اجازه میدهد اطلاعات را از منابع معتبر بهصورت مستقیم بازیابی کند. بااینحال، این راهکار نیز محدودیتهایی دارد؛ زیرا اگر منابع آنلاین که مدل جستوجو میکند معتبر نباشند، این روش هم نمیتواند عامل مؤثری باشد.

علاوه بر این، افزایش شفافیت در فرآیند آموزش مدلها و ارائه توضیحات دقیقتر در مورد نحوه کارکرد آنها میتواند به کاربران در ارزیابی قابلیتهای مدل کمک کند. نوآوری در معماری الگوریتمها و استفاده از شیوههای جدید یادگیری نظارتی میتواند به کاهش نرخ خطا کمک شایانی کند. همچنین، شبیهسازی شرایط واقعی و افزایش دادههای آزمون در محیطهای گوناگون از دیگر راهکارهای پیشنهادشده است.

نقش کاربران و مسئولیت پذیری OpenAI

یکی از مسائلی که باید برجسته شود، نقش کاربران نهایی در بهرهبرداری از مدلهای هوش مصنوعی است. آموزش و آگاهیرسانی به کاربران به آنها کمک میکند تا در هنگام استفاده از این مدلها، اطلاعات تولیدشده را با دقت بیشتری ارزیابی و بررسی کنند. همچنین، شرکتهایی مانند OpenAI باید مسئولیت بیشتری در قبال خطاهای این مدلها بپذیرند و به صورت شفافتر در مورد محدودیتها و ضعفهای محصولات خود اطلاعرسانی کنند.

افکار نهایی

مدلهای جدید OpenAI نظیر o3 و o4-mini فرصتی برای پیشبرد تواناییهای هوش مصنوعی ارائه دادهاند، اما این پیشرفتها با چالشهایی نظیر افزایش نرخ توهم همراه بوده است. برای رفع این چالشها، نیاز به همکاری جامعه هوش مصنوعی، نهادهای نظارتی و کاربران است تا این تکنولوژی با حداقل خطا و حداکثر بهرهوری به کار گرفته شود.

آیا شما تجربهای درخصوص استفاده از این مدلها یا سایر ابزارهای هوش مصنوعی دارید؟ نظرات خود را پیرامون چالشهای مطرحشده با ما و سایر خوانندگان به اشتراک بگذارید!

دیدگاه ها