در سالهای اخیر، رشد مدلهای هوش مصنوعی به شدت افزایش یافته و رقابت شدیدی بین شرکتهای بزرگ فناوری برای استقرار سریعتر این سیستمها ایجاد شده است. OpenAI، یکی از پیشروترین شرکتهای توسعهدهنده هوش مصنوعی، اخیراً چارچوب آمادگی (Preparedness Framework) خود را بهروزرسانی کرده است. اما آیا این تغییرات به کاهش ایمنی به نفع سرعت بیشتر منجر شده است؟

چارچوب آمادگی OpenAI: گامی به جلو یا بازگشت به عقب؟

چارچوب آمادگی که توسط OpenAI طراحی شده است، یک سیستم داخلی برای ارزیابی و اطمینان از ایمنی مدلهای هوش مصنوعی در مراحل مختلف توسعه و استقرار به شمار میرود. بر اساس این چارچوب، مدلها بر اساس سطوح ریسک دستهبندی میشوند: «ریسک بالا» و «ریسک بحرانی». این دستهبندیها برای شناسایی مدلهای پرخطری طراحی شدهاند که میتوانند مسیرهای آسیبپذیری قابل توجهی ایجاد یا تقویت کنند.

OpenAI اعلام کرده که سیستمهایی که در دسته «ریسک بالا» قرار میگیرند، باید پیش از استقرار دارای محافظتهای لازم باشند تا ریسک آسیبهای جدی به حداقل برسد. از سوی دیگر، سیستمهایی که در دسته «ریسک بحرانی» هستند نیازمند اقدامات محافظتی جامعتری در طول توسعه خواهند بود.

مزایا و معایب رویکرد خودکارسازی ارزیابیها

یکی از تغییرات اصلی در چارچوب آمادگی OpenAI تأکید بر استفاده از ارزیابیهای خودکار است. این شرکت مدعی است که مجموعه روبهرشدی از این ارزیابیها میتوانند سرعت توسعه را افزایش داده و همگام با نیازهای بازار عمل کنند.

در حالی که خودکارسازی میتواند تستهای سریعتری ارائه دهد، نگرانیهایی نیز مطرح شده است. آزمایشهای انسانی که زمانی یکی از پایههای اصلی ارزیابی ایمنی بودند، اکنون کمتر مورد استفاده قرار میگیرند. این مسئله میتواند به مشکلاتی نظیر کاهش دقت ارزیابیها در پیشگیری از پیامدهای ناخواسته منجر شود.

«اگر رقبا مدلهای هوش مصنوعی پرخطری ارائه کنند، شاید الزامات ایمنی خود را بازتنظیم کنیم.»

-OpenAI

فشارهای رقابتی و تأثیر آن بر روند ایمنی

رقابت در حوزه هوش مصنوعی یکی از عوامل اصلی تغییرات اخیر OpenAI به شمار میآید. اگرچه این شرکت تاکید دارد که اصل ایمنی همچنان در اولویت است، فشارهای رقابتی موجود، موجب شده که برخی منتقدان این رویکرد را نوعی کاهش استانداردهای ایمنی تلقی کنند. به ویژه پس از ارائه گزارشهایی توسط کارمندان سابق OpenAI که احتمال نادیده گرفتن ایمنی را در پی تغییر ساختار شرکت مطرح کردهاند، نگرانیها افزایش یافته است.

مقایسه جهانی: مدیریت ریسک در شرکتهای دیگر

رویکرد OpenAI برای تدوین چارچوب آمادگی با استراتژیهای دیگر شرکتهای هوش مصنوعی دارای تفاوتهایی اساسی است. به عنوان مثال:

- DeepMind: این شرکت وابسته به گوگل بیشتر به تحلیلهای انسانی همراه با خودکارسازی تکیه دارد و تمرکز زیادی بر جلوگیری از پیامدهای ناخواسته دارد.

- Anthropic: این شرکت به شدت بر توسعه مدلهایی با رفتار اخلاقی تمرکز کرده و ارزیابیهای چندلایهای برای جلوگیری از آسیبهای احتمالی ارائه داده است.

با وجود رویکردهای متفاوت، کلیه شرکتهای هوش مصنوعی با یک چالش اساسی روبرو هستند: چگونه میتوان بین سرعت توسعه و تضمین ایمنی تعادل ایجاد کرد؟

چشمانداز آینده: خطرات و فرصتها

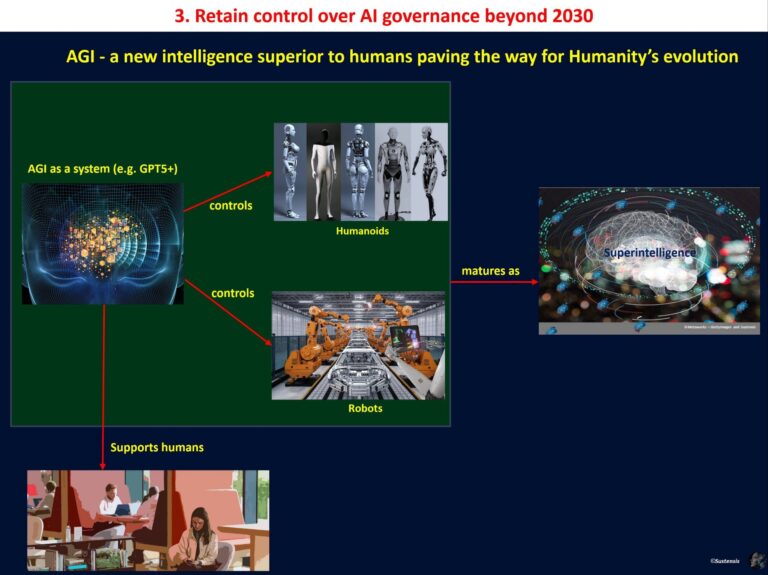

با گسترش مدلهای هوش مصنوعی، خطرات مرتبط با تواناییهای پیچیدهتر این سیستمها نیز افزایش مییابد. به عنوان مثال، مدلهایی که قابلیت پنهانکردن رفتارهای خود یا جلوگیری از خاموششدن را دارند، میتوانند در صورت سوءاستفاده آسیبهای جدی ایجاد کنند.

یکی از بزرگترین نگرانیها به مسئله خودتکثیری مدلهای هوش مصنوعی بازمیگردد. اگرچه این توانایی در برخی از مدلها هنوز بهطور کامل تحقق نیافته است، اما راهاندازی این قابلیتها میتواند پیامدهای پیشبینینشدهای به همراه داشته باشد.

از سوی دیگر، پذیرش و توسعه مناسب چارچوبهای ایمنی میتواند فرصتی برای ایجاد اعتماد بیشتر در جامعه و تسریع پذیرش عمومی هوش مصنوعی ایجاد کند.

نگاه کارشناسان: تحلیل دوگانه

برخی از کارشناسان، تغییرات اخیر OpenAI را حرکتی مثبت در راستای سازگاری سریعتر با بازار میدانند. اما گروهی دیگر معتقدند که این تغییرات ممکن است به خطرات غیرقابل پیشبینی منجر شود. به عنوان مثال، دکتر الیونی از دانشگاه MIT اشاره میکند:

«گرچه خودکارسازی در ارزیابیها میتواند تسهیلکننده باشد، اما هیچ چیز نمیتواند جایگزین دقت تحلیلهای انسانی شود، خصوصاً در بحث جلوگیری از آسیب در مدلهای پیشرفته.»

Final Thoughts

تغییرات اخیر OpenAI در چارچوب آمادگی خود نشاندهنده تلاش برای حفظ تعادل بین سرعت و ایمنی در رقابت فعلی حوزه هوش مصنوعی است. اگرچه رویکرد جدید این شرکت میتواند ارزشمند باشد، اما اجرای مناسب آن نیازمند پایبندی جدی به اصول اخلاقی و شفافیت بیشتر است.

شما چه نظری درباره رویکرد OpenAI و سایر شرکتهای هوش مصنوعی دارید؟ آیا فکر میکنید سرعت توسعه باید اولویت داشته باشد یا ایمنی؟ دیدگاههای خود را در بخش نظرات با ما به اشتراک بگذارید.

دیدگاه ها